Zustandsüberwachung von Bahn oberleitungen mit Kameradrohnen

←

→

Transkription von Seiteninhalten

Wenn Ihr Browser die Seite nicht korrekt rendert, bitte, lesen Sie den Inhalt der Seite unten

FAHRWEG

Zustandsüberwachung von Bahn

oberleitungen mit Kameradrohnen

Im vom BMVI geförderten Projekt SMARAGD untersuchen Siemens, DLR und Copting

luftgestützte Verfahren zur prädiktiven Instandhaltung der Bahninfrastruktur.

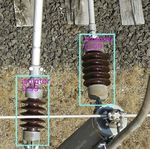

Abb. 1: Luftbildaufnahme einer Eisenbahnstrecke mit detektierten Isolatoren an der Oberleitung. Bei dem verwendeten System kann im Abstand

von 20 m eine Auflösung von 1 mm erreicht werden, im Abstand von 40 m etwa 2 mm. Details werden somit erkennbar. Quelle: DLR

FRANZ ANDERT | NILS KORNFELD | FLORIAN Einleitung des vor Ort wird die Zeitdauer von Strecken-

NIKODEM | HAIYAN LI | STEFAN KLUCKNER | Bauwerke der Eisenbahninfrastruktur, bei- sperrungen minimiert, da die Befliegungen

LAURA GRUBER | CHRISTIAN KAISER spielsweise Oberleitungen, müssen re- der Strecke wesentlich kürzer ausfallen als

gelmäßig einer Sichtprüfung unterzogen herkömmliche Begehungen zur Sichtprüfung.

werden. Um Einschränkungen im regulären Zudem können die schwer zugänglichen Ele-

Im Projekt SMARAGD wird untersucht, mit Betrieb zu vermeiden, werden diese Arbei- mente aus nahezu beliebigen Blickwinkeln

welchen Methoden unbemannte Luftfahr- ten oft als Wochenendarbeit oder Nacht- aufgenommen werden.

zeuge zur prädiktiven Instandhaltung schichten meistens zusammen mit Stre-

von Bahnoberleitungen eingesetzt wer- ckensperrungen ausgeführt und sind daher Projektziele

den können. Hierzu wird ein Multikopter personal-, zeit- und kostenintensiv. Heute

mit einem hochauflösenden Kamerasys- werden betriebsrelevante Elemente wie Iso- Motivation

tem ausgestattet und testweise über ver- latoren (Abb. 2) üblicherweise zyklisch zur Langfristiges Ziel ist es, sowohl die Beflie-

schiedenen Bahnstrecken eingesetzt. An- Risikominimierung ausgetauscht, wodurch gung als auch die Datenauswertung wei-

hand der Bilddaten lassen sich Elemente sich die Lebensdauer jedoch stärker als nö- testgehend zu automatisieren. Die mit Sen-

wie Isolatoren automatisch identifizieren tig reduziert. Dies gilt insbesondere für Ele- sorik ausgestatteten Luftfahrzeuge sollen

und verorten. Mithilfe von Künstlicher mente, die für Inspektion und Tausch nur in vordefinierten Abständen selbstständig

Intelligenz (KI) sollen die einzelnen Ele- schwer erreichbar sind. In Zukunft soll die die Bahninfrastruktur abfliegen und Daten

mente überwacht werden. Neben der Instandhaltung zustandsorientiert, bis hin aufnehmen. Anschließend werden die Da-

Entwicklung von Detektionsalgorithmen zur Vorhersage des Abnutzungsverhaltens, ten automatisch auf die zu untersuchenden

wird untersucht, welche Genauigkeit mit erfolgen. Letzteres wird auch als predictive Elemente überprüft. Mithilfe einer geeig-

Kamera- und Videodaten erreicht wer- health management (PHM) bezeichnet. neten Mustererkennungssoftware können

den kann. Da die Befliegung von Bahn- Eine automatische Befliegung mit unbemann- automatisch Defekte und Veränderungen in

strecken nicht ohne weiteres erlaubt ist, ten Luftfahrzeugen kann zu einer erheblichen den Scandaten erkannt und lokalisiert wer-

untersucht das Projekt rechtliche und or- Reduzierung der Kosten bei gleichzeitiger den. Dazu werden die Bildaufnahmen aus

ganisatorische Aspekte zum sicheren Be- Verbesserung der Diagnosegüte beitragen. vergangenen Wartungsflügen mit den aktu-

trieb von unbemannten Luftfahrzeugen. Neben der Reduzierung des Personalaufwan- ellen Aufnahmen übereinander gelegt und

10 EI | MAI 2020 Nutzung unter www.siemens.com zeitlich unbefristet genehmigt durch DVV Media GmbH, 2021FAHRWEG

Abb. 2: Abplatzung an einem Isolator. Diese und weitere Schäden sollen durch Befliegungen automatisch erkannt werden.

Quelle: DB Netz AG Bereich Oberleitung Braunschweig

zusätzlich mit den Bildern aus einer Refe- Inhalt des Projekts GmbH eigens für dieses Projekt konfigurier-

renzdatenbank verglichen. Bei signifikanten Die Erkennung der zu untersuchenden Objek- ter Multikopter, der mit einer beweglichen

Änderungen in der Infrastruktur – z. B. Riss- te und die Klassifikation von verschiedenen und hochauflösenden Kamera (42 Megapi-

bildung, Rost und weitere Defekte – werden Zustands- und Schadensarten soll automa- xel) ausgestattet ist (Abb. 3). Hiermit wird die

die Ergebnisse dem Anwender automatisch tisiert werden. Hierzu werden verschiede- Qualität einer automatisierten Datenverar-

visualisiert und in aufgearbeiteter Form zur ne Verfahren zur automatischen Bild- und beitung zur Erkennung von Isolatoren unter

Verfügung gestellt. Diese automatische Aus- Videoanalyse erforscht. Im Projekt werden Realbedingungen untersucht. Die Erkennung

wertung und die entsprechende Visualisie- dabei zwei verschiedene Versuchsträger zur der Isolatoren erfolgt dabei mithilfe von Ver-

rung würden die Wartungsarbeitsschritte Befliegung von Eisenbahnstrecken ausgerüs- fahren der KI. Das zweite System ist ein han-

erheblich vereinfachen und beschleunigen. tet: Das erste System ist ein von der Copting delsüblicher Multikopter (DJI Mavic) mit ein-

Abb. 3: Copting TransformerUAV Hexacopter bei der Aufnahme von Oberleitungen Quelle: Copting GmbH

Nutzung unter www.siemens.com zeitlich unbefristet genehmigt durch DVV Media GmbH, 2021 EI | MAI 2020 11FAHRWEG

i Verwendung von Künstlicher Intelligenz

Die Objektdetektion erfolgt mit modernen Ver-

Genehmigungslage für den Betrieb unbemannter Luftfahrzeuge fahren der KI, sogenannten neuronalen Netzen

Der Betrieb unbemannter Luftfahrzeuge ist durch die Luftverkehrsordnung (LuftVO) regu- [1]. Bei dem hier eingesetzten Verfahren werden

liert und für den kommerziellen Einsatz grundsätzlich genehmigungspflichtig. In 2020 wird zunächst in einem gegebenen Bilddatensatz

eine Überarbeitung der rechtlichen Rahmenvorschriften erwartet, welche die Vorschläge Objekte in den Bildern manuell annotiert. Dies

der European Aviation Safety Agency [6] umsetzen soll. Hierzu gehört die Unterteilung von ergibt den Trainingsdatensatz mit Bildern und

unbemannten Luftfahrtmissionen in verschiedene Risikokategorien sowie Systematiken

den zu lernenden Annotationen. Das System

zur Bewertung und Vermeidung von Risiken [7]. Maßgeblich sind das Luftrisiko (z. B. durch

Verletzung von Lufträumen) und das Bodenrisiko (z. B. Flug über bewohntem Gebiet und in lernt dann selbstständig ein Modell mit den Pa-

der Nähe Kritischer Infrastruktur) in Abhängigkeit des Einsatzgebietes, den Eigenschaften, rametern der annotierten Objekte. Dieses Mo-

Fähigkeiten und Sicherheitssystemen des Luftfahrzeugs sowie weiteren organisatorischen dell kann nun verwendet werden, um Objekte

Maßnahmen zur Risikovermeidung. Aufgrund der Systematik zur Risikobewertung lassen in neuen Bildern automatisch zu identifizieren.

sich Standardszenarien wie das JARUS STS-01 [8] ableiten. Hier werden Bedingungen und Die Parameter in diesem Modell bestimmen die

Maßnahmen für den Flugbetrieb mit kleineren Luftfahrzeugen bis 3 m Durchmesser über typischen visuellen Eigenschaften der zu klas-

größere Entfernungen beschrieben, was den besonders riskanten Flug außer Sicht mit ein- sifizierenden Objekte auf unterschiedlichsten

schließt. Auf dieser Grundlage können damit Flüge an Bahnstrecken für entsprechend au-

torisierte Betreiber durchgeführt werden.

Abstraktionsebenen. Sie enthalten primitive

Eigenschaften wie Kanten oder Farben sowie

auch weitaus komplexere Formen und Muster

[2]. Ein weiterer Überblick zu aktuellen Imple-

mentierungen ist in [3] zu finden.

Die hierbei verwendete Netzarchitektur ist

ein Single Shot Detector [4], der mehrere

Objekte in einem Bild gleichzeitig erkennen

kann und bei hohen Bildauflösungen und

größeren Objekten im Bild performant ist. Da-

mit die Objekte auch aus unterschiedlichen

Blickwinkeln identifiziert werden können,

werden z. B. auch verdrehte und verzerrte

Originalbilder in die Lernphase einbezogen.

Letztendlich wurden ungefähr 44 000 Bilder

für das Training des Modells verwendet.

Um das Verfahren und das trainierte Modell

zu testen, wurde ein Testdatensatz von 5000

weiteren Bildern mit reduzierter Auflösung

sowie 243 voll aufgelöste Bilder aus den Flug-

Abb. 4: Beispiele zur Detektion von Isolatoren. Während aus einem idealen Blickwinkel eine versuchsdaten verwendet. Die Ergebnisse

Detektion mit sehr hoher Genauigkeit erkannt wird (links), ist die Detektion trotz Training des sind in Tab. 1 aufgelistet. Zur Bewertung die-

Modells unter bestimmten Blickwinkeln wesentlich schwieriger (rechts). Dieser Isolator wird auch nen die in der Statistik gebräuchlichen Klassi-

nach Herabsetzen von Klassifikationsschwellwerten nicht erkannt. Quelle: Siemens Mobility GmbH fikationsmaße Genauigkeit und Trefferquote.

Die sehr hohe Genauigkeit bedeutet, dass nur

etwa 2-3 % der detektierten Objekte keine Iso-

gebauter 4K-Videokamera. Mit den Daten aus te und damit höherer Objektauflösung wurde latoren darstellen. Im Gegensatz dazu bedeutet

den Befliegungen soll untersucht werden, verzichtet, um bei den Befliegungen mög- die Trefferquote, dass etwa 30 % der Isolatoren

inwieweit langfristig auch handelsübliche lichst viele Elemente erfassen zu können. Dies nicht gefunden werden. Neben der vergleichs-

Fluggeräte ohne spezielle Hardware für den stellt zunächst einen sinnvollen Kompromiss weise schlechteren Detektion bei größeren Ent-

Einsatz verwendet werden können. Ziel ist zwischen Auflösung und Vollständigkeit der fernungen zeigt Abb. 4 ein Beispiel, unter denen

die Aufbereitung von Videodaten, sodass sie erfassten Objekte dar, da der Zustand eines eine Detektion schwierig ist. Derartige Erkennt-

Einzelbilder aus einer Kamera mit wesentlich Isolators grundsätzlich erkennbar ist. nisse sind für die weitere Planung von Befliegun-

höherer Auflösung ersetzen können. Gelingt Bei der Objektdetektion sollen diejenigen gen von Bedeutung. Beispielsweise sollte eine

dies, können im kommerziellen Betrieb han- Bildregionen identifiziert werden, in denen bekannte Bahnstrecke so beflogen werden, dass

delsübliche und vergleichsweise günstige sich Isolatoren befinden. Aus einer automa- eine seitliche Ansicht der Isolatoren erreicht wird.

Fluggeräte eingesetzt werden. tischen Befliegung lassen sich damit die-

jenigen Bilder aussortieren, in denen keine Übertragung auf Videodaten

Automatisierte Bilddatenverarbeitung Isolatoren zu sehen sind. Zudem genügt es, mit geringerer Auflösung

Das verwendete Kamerasystem ermöglicht für weitere Verarbeitungsschritte nur die Im kommerziellen Betrieb kann es vorteilhaft

eine Objektauflösung von etwa 1 mm pro Pixel entsprechenden Bildregionen zu verwen- sein, handelsübliche und in großer Stückzahl

bei einem Abstand von 20 m zu einem Isolator den, womit sich die weiter zu prozessierende verfügbare Fluggeräte zu verwenden. Als Bei-

(Abb. 1). Auf Objektive mit höherer Brennwei- Datenmenge reduziert. spiel wird hier die Anwendung eines Multi

kopters vom Typ DJI Mavic evaluiert. Wie

eine Vielzahl anderer Geräte ist dieses System

Anzahl Bilder Genauigkeit Trefferquote mit einer Kamera ausgestattet. Da sich die

Aufnahme von Einzelbildern oft nicht mit

5000 mit reduzierter Auflösung 0,98 0,72 ausreichender Präzision steuern lässt, wer-

243 Originalbilder 0,968 0,70 den Videodaten für die weitere Auswertung

betrachtet. Idealerweise genügt dann eine

Tab. 1: Genauigkeit (Precision, mAP0.5) und Trefferquote (Recall) der Detektion objektnahe Befliegung der Bahnstrecke ohne

12 EI | MAI 2020 Nutzung unter www.siemens.com zeitlich unbefristet genehmigt durch DVV Media GmbH, 2021FAHRWEG

Abb. 5: Prinzip der Super-Resolution. Dabei wird die Transformation zwischen mehreren Bildern einer Sequenz auf Subpixelebene bestimmt und ein

fusioniertes Bild mit höherer Auflösung errechnet. Quelle: DLR

besondere Haltepunkte, was insbesondere on der Artefakte und zur Erhöhung der resul- vigation die Zuordnung hochgenauer Posi-

für längere Streckenabschnitte von Vorteil ist. tierenden Auflösung geforscht. tionsdaten zu den jeweiligen Einzelbildern.

Wesentlicher Nachteil der Videodaten ist Dies ermöglicht neben der Bewertung des

die geringere Bildauflösung im Vergleich zu Automatisierte Georeferenzierung Objektzustands aus verschiedenen Perspek-

den Spezialkameras sowie die Verwendung von erkannten Objekten tiven die Rekonstruktion von 3D-Informatio-

verlustbehafteter Datenkompression. Daher Das implementierte Flugmanagement er- nen. Mittels photogrammetrischer Verfahren

wird untersucht, inwieweit sich mehrere Ein- möglicht das Sammeln von Bild- und Video- werden die Aufnahmepositionen in genaue

zelbilder des Videos zu einem Gesamtbild hö- material aus unterschiedlichen Ansichten auf Relation zueinander gebracht und es wird die

herer Auflösung kombinieren lassen und ob die Objekte. Zudem erfolgt mit Satellitenna- 3D-Position der jeweiligen Objekte triangu-

ein derart errechnetes Bild auch tatsächlich

detailliertere Strukturen aufweist. Das Grund-

prinzip ist als Super-Resolution bekannt [5]

und in Abb. 5 dargestellt. Hierzu müssen sig-

nifikante Merkmale mehrerer Einzelbilder auf

Subpixelebene genau bestimmt werden.

Um den tatsächlichen Auflösungsgewinn zu

beurteilen, wurde mit dem Multikopter das

Bild eines Siemenssterns gefilmt und aus 16

Bildern der Sequenz ein Bild mit vierfacher

Auflösung berechnet. Abb. 6 zeigt das Ergeb- ¡ Ingenieur- und

nis. Hierbei ist einerseits die tatsächliche Erhö- Bahnvermessung

hung der Auflösung zu erkennen, andererseits Industriestraße 3

zeigen sich hier auch Artefakte am unteren

¡ UAV Vermessung 76189 Karlsruhe

Bildrand. Ursache können unter anderem In- ¡ Monitoring Tel. 0721 / 79072-0

formationsverluste durch Kompression der Fax 0721 / 79072-10

¡ 3D Modellierung info@it-geo.de

Eingangsbilddaten sein. Insgesamt überwiegt

allerdings der Nutzen dieser Technik. Derzeit ¡ Hydrographie www.it-geo.de

wird aktiv an Methoden zur weiteren Redukti-

Nutzung unter www.siemens.com zeitlich unbefristet genehmigt durch DVV Media GmbH, 2021 EI | MAI 2020 13FAHRWEG

Abb. 6: Links: Beispielbild einer Videoaufnahme eines Siemenssterns. Rechts: Erstellung eines höher aufgelösten Bildes mittels Super-Resolution.

Je nach Qualität der Eingabedaten können hier jedoch auch unerwünschte Artefakte entstehen. Quelle: DLR

[5] Mitzel, D. et al.: Video super resolution using duality based TV-L 1 optical

liert. Durch die genaue relative Lokalisierung flow. DAGM Joint Pattern Recognition Symposium, 2009, S. 432-441

können die Objekte damit eindeutig identifi- [6] European Aviation Safety Agency (EASA): Introduction of a regulatory

ziert werden, wobei ein absoluter Positions- framework for the operation of drones. Technical Opinion, A-NPA 2015-10, 2015 Haiyan Li, M. Sc.

[7] Joint Authorities for Rulemaking of Unmanned Systems (JARUS):

fehler in Größenordnung der Satellitennavi- Guidelines on Specific Operations Risk Assessment (SORA). Online: http://

Softwareentwicklerin

gation von etwa 0,5 m bis 1 m verbleibt. Die jarus-rpas.org/sites/jarus-rpas.org/files/jar_doc_06_jarus_sora_v2.0.pdf, Siemens Mobility GmbH, Berlin

Zugriff am 02.03.2020, 17:00 Uhr haiyan.li.ext@siemens.com

georeferenzierten Bild- und Zustandsdaten

[8] Joint Authorities for Rulemaking of Unmanned Systems (JARUS): SORA

einzelner Objekte lassen sich damit automa- STS-01 for Aerial Work Operations, Version 1.1. Online: http://jarus-rpas.org/

tisiert mit Datenbanken abgleichen. sites/jarus-rpas.org/files/jar_doc_6_sora_sts_01_edition1.1.pdf, Zugriff

am 02.03.2020, 17:00 Uhr

Zusammenfassung

Im Projekt wurden mehrere Bahnstrecken zur

Bild- und Videodatenaufnahme beflogen. Die

Ergebnisse zeigen die Möglichkeiten einer au-

tomatisierten Bildauswertung. Hierbei können Dr.-Ing. Franz Andert Dipl.-Ing. Dr. techn. Stefan Kluckner

Isolatoren aus einer Entfernung von 20 m derart Gruppenleiter Sensorsysteme Abteilungsleiter Computer Vision and

identifiziert werden, dass der Zustand des Isola- Institut für Verkehrssystemtechnik Graphics Applications

tors erkennbar wird. Zudem kann gezeigt wer- Deutsches Zentrum für Luft- und Siemens Mobility GmbH, Berlin

den, dass unter guten Voraussetzungen auch Vi- Raumfahrt, Berlin stefan.kluckner@siemens.com

deodaten handelsüblicher Multikopter anstelle franz.andert@dlr.de

von hochaufgelösten Bildern verwendet werden

können. Daraus ergeben sich Anwendungsmög-

lichkeiten unter realen Einsatzbedingungen und

unter Verwendung von handelsüblicher Hard-

ware.

Die Arbeiten wurden durchgeführt im Rahmen Nils Kornfeld, M. Sc. Laura Gruber

des Verbundprojektes SMARAGD (Smart MAinta- Wissenschaftlicher Mitarbeiter Projektleiterin SMARAGD

nance of Rail infrastructure by using Analytical Institut für Verkehrssystemtechnik Business Development und Strategie

Georeferenced Data Services), gefördert vom Deutsches Zentrum für Luft- und im Customer Service

Bundesministerium für Verkehr und Digitale In- Raumfahrt, Berlin Siemens Mobility GmbH, Braun-

frastruktur (BMVI) mit der Forschungsinitiative nils.kornfeld@dlr.de schweig

mFund, Förderkennzeichen 19F2055B. laura.gruber@siemens.com

QUELLEN

[1] Howard, A. G. et al.: MobileNets: Efficient convolutional neural networks

for mobile vision applications. arXiv:1704.04861 [cs.CV], 2017

[2] Geirhos, R. et al.: ImageNet-trained CNNs are biased towards texture;

increasing shape bias improves accuracy and robustness. International Florian Nikodem, M. Sc. Dipl.-Inf. Christian Kaiser

Conference on Learning Representations (ICLR), 2019

[3] Huang, J. et al.: Speed/accuracy trade-offs for modern convolutional Wissenschaftlicher Mitarbeiter Geschäftsführer

object detectors. IEEE Conference on Computer Vision and Pattern Institut für Flugsystemtechnik Copting GmbH

Recognition (CVPR), 2017 Deutsches Zentrum für Luft- und ckaiser@copting.de

[4] Liu, W. et al.: SSD: Single shot multibox detector. European Conference on Raumfahrt, Braunschweig

Computer Vision (ECCV), 2016, S. 21-37

florian.nikodem@dlr.de

14 EI | MAI 2020 Nutzung unter www.siemens.com zeitlich unbefristet genehmigt durch DVV Media GmbH, 2021Sie können auch lesen